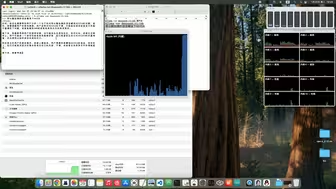

完整版DeepSeek-R1 671b本地部署 速度瓶颈深度剖析

作者: parodic

作者简介:

描述: 我在进行DeepSeek-R1的不同蒸馏量化版本,以及包含671b参数的Q4量化版本和1.58,2.22bit动态量化版本的本地部署的尝试,完全使用CPU而非GPU来进行不同参数数量的模型的本地推理。在此过程中发现,利用CPU进行LLM部署和推理的限速瓶颈在于系统内存带宽。即便使用了具有12通道内存的EPYC 9B14 CPU,也存在明显的内存带宽瓶颈,导致CPU线程数在32以上时,token输出速度就趋于饱和,与单线程相比,32线程时的加速比不到0.15,更高的线程数甚至会降低输出速度。这表明现有的CPU硬件和算法无法在LLM本地部署过程中有效利用CPU的运算能力。