Transformer和BERT看不懂来这里,告诉你他们的前世今生,必能懂

作者: 水论文的程序猿

作者简介: B站含水量最高的导。私信关键字“粉丝群”,自动回复你入群方式,能看到就是还有坑位~

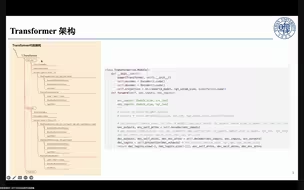

描述: 我们为什么要从预训练语言模型的前世今生去讲解 Transformer 和 BERT 呢?什么是预训练,什么是语言模型,为什么它会存在一个前世今生呢?一步一步的讲解,将让你明白 BERT 的出现并不是横空出世,它是集大成者,也是人类智慧的结晶,引领人工智能领域…… 博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链接:https://github.com/nickchen121/Pre-training-language-model 配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html